TRIBUNE. L’association #JamaisSansElles, engagée depuis plusieurs années dans des actions concrètes en faveur de la mixité, plaide pour le volontarisme face aux biais et stéréotypes de l’intelligence artificielle. Elle a lancé une campagne d’affichage nationale le 8 mars dernier avec Havas Paris.

par Tatiana F-Salomon, présidente fondatrice, et Étienne Parizot, vice-président de #JamaisSansElles, publié dans Le Point, le 8 mars 2023.

Engagée depuis plusieurs années par des actions concrètes en faveur de la mixité au sein des entreprises et des institutions, notre association #JamaisSansElles ne peut rester insensible à la montée en puissance de l’Intelligence artificielle (IA) et aux bouleversements qu’elle génère déjà dans l’ensemble de la société, dont certains pourraient bien remettre en cause les récents progrès accomplis en matière d’égalité entre les femmes et les hommes. C’est pourquoi nous lançons aujourd’hui une campagne nationale sur les biais dans l’IA et alertons sur les défis à relever.

Engagée depuis plusieurs années par des actions concrètes en faveur de la mixité au sein des entreprises et des institutions, notre association #JamaisSansElles ne peut rester insensible à la montée en puissance de l’Intelligence artificielle (IA) et aux bouleversements qu’elle génère déjà dans l’ensemble de la société, dont certains pourraient bien remettre en cause les récents progrès accomplis en matière d’égalité entre les femmes et les hommes. C’est pourquoi nous lançons aujourd’hui une campagne nationale sur les biais dans l’IA et alertons sur les défis à relever.

Au Moyen-Âge, la question du sexe des anges alimentait de nombreux débats scolastiques. Intelligences surnaturelles ou purs esprits, les anges n’étaient-ils pas évidemment neutres ? Pourtant, leurs diverses personnifications et représentations semblaient toujours renvoyer à des hommes. Au point que l’expression « discuter du sexe des anges » fut bientôt employée en référence à une occupation absurde et dérisoire, tant la cause, en effet, paraissait entendue ! Quelques siècles plus tard, devrons-nous nous soucier du genre de nos intelligences artificielles ? Car derrière l’apparente neutralité que leur confère l’image mythique d’une pure abstraction numérique se cache un enjeu de taille, déterminant pour le développement de nos sociétés.

Une campagne d’affichage nationale sur les biais dans l’IA

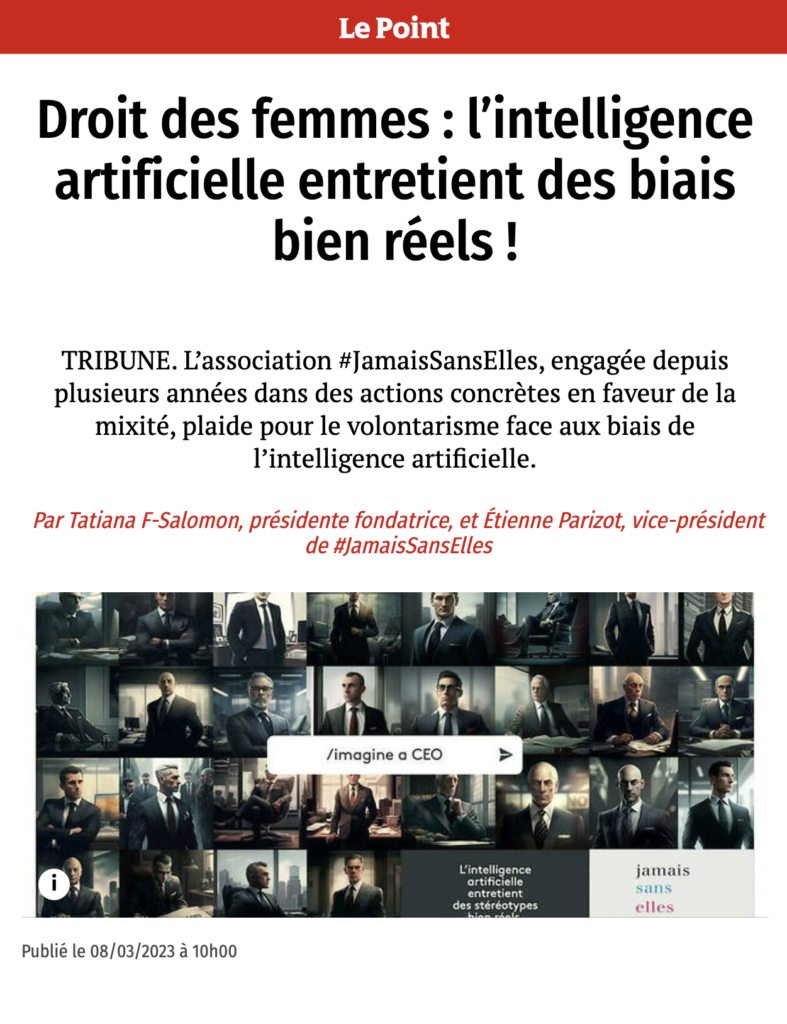

L’IA, certes, ignore tout du sexe des humains : elle ne connaît que des juxtapositions de pixels dans des banques d’images numériques ou des successions de lettres sans signification particulière, recueillies dans des milliards de textes et amassées dans des bases de données gigantesques. Mais ces données – ces « data », comme on dit – ne sont quant à elles ni abstraites, ni neutres : elles sont le reflet direct non seulement de la société dans laquelle nous vivons, mais aussi des choix partiellement arbitraires de ceux qui les rassemblent et les organisent. Elles nous ressemblent tant que même en étant aveugle à leur « signification », l’IA y décèle sans effort les préjugés communs qui les ont générées, les biais disséminés dans leur structure et leurs associations internes. Ce n’est pas par erreur qu’une IA à qui l’on demande de représenter une personne exerçant la chirurgie peut proposer l’une après l’autre des dizaines d’images de chirurgien, sans y faire apparaître la moindre femme. Ce n’est pas par erreur non plus que la requête d’une image de PDG aboutit presque systématiquement à la reconstitution d’un visage masculin, occidental, autour de la cinquantaine. C’est que ce type d’images est très largement surreprésenté dans les banques de données numériques ayant servi à entraîner les algorithmes. Le biais peut même aller jusqu’au stéréotype grossier, lorsqu’on voit par exemple une IA générative produire comme par évidence des images de secrétaires non seulement exclusivement féminines, mais de surcroît hypersexualisées. Ces associations quasi-automatiques ne sont pas des anomalies des IA. Bien au contraire, c’est parce que les IA sont performantes qu’elles les proposent avec tant d’insistance. Elles ne les produisent pas : elles les reproduisent. Fidèlement.

Ce n’est plus l’IA qui nous suit, mais nous qui suivons l’IA

Faut-il s’en inquiéter ? Sans doute les représentations majoritaires ou implicites que l’IA retranscrit sauront-elles s’adapter en suivant l’évolution de nos mentalités et la transformation de nos sociétés. Sauf que… le jeu pourrait bien être en train de s’inverser ! Avec l’essor des applications à base d’IA et des « modèles de langage » associés, dont le fameux chatGPT n’est que l’un des premiers avatars rendus largement accessibles, nous devons nous préparer à la diffusion massive de contenus générés par des outils laissant de moins en moins de place à une intervention humaine. Ce qui s’est déjà installé, c’est bien un scénario où ce n’est plus l’IA qui nous suit, mais nous qui suivons l’IA. Le processus de renforcement est implacable : nos biais présents sont captés par l’IA, transcrits dans ses modes de manipulation des données, systématisés puis restitués dans les images et les textes qui nous sont présentés, mais aussi à travers les produits, loisirs, conseils d’orientation et emplois qui nous sont proposés. En suivant ces recommandations, nous les validons, et en les validant, nous les justifions a posteriori, et proclamons leur pertinence. Échec et mat.

Déjà les algorithmes de LinkedIn, par exemple, proposent aux hommes et aux femmes des opportunités d’emploi distinctes. Pourquoi ? Parce que la statistique est implacable. Ce ne sont pas les IA qui sont biaisées. Ce sont les données dont nous les nourrissons. Et les biais de genre y sont effectivement nombreux, comme d’ailleurs d’autres formes de discrimination. L’exemple de la représentation des femmes dans la tech est emblématique. Mais il y en a bien d’autres. Plus subtils, moins manifestes, car encore trop intégrés à nos modes de pensée et de représentation. Ceux-ci évoluent, bien sûr, sur le terrain philosophique comme dans le champ social ou le milieu professionnel. Mais le danger est grand de voir l’IA figer durablement des biais dont on commence à peine à prendre conscience, les faisant passer d’implicite à explicite, d’occasionnel à systématique, et retardant ainsi, voire compromettant une évolution sociétale éminemment souhaitable et demandée par une population de plus en plus sensibilisée aux questions d’égalité et d’inclusion. C’est pourquoi il est urgent d’intervenir avant que ne se cristallisent, au cœur des algorithmes qui gouvernent déjà largement nos vies personnelles et professionnelles, les biais dont nous voudrions collectivement nous affranchir.

Les bouleversements induits par l’IA constituent des défis de taille

Ne nous y trompons pas : rien n’empêchera l’envahissement rapide de notre environnement informationnel par des contenus générés par les IA. Il ne s’agit pas de s’y opposer, mais d’examiner avec attention les modes d’opération de ces nouveaux outils et d’identifier les leviers que nous pourrions actionner pour les mettre à notre service. Car l’IA, savamment employée, pourrait aussi se montrer une précieuse alliée dans la marche de la société vers davantage d’égalité, notamment entre les hommes et les femmes. Elle pourrait alors faire partie du problème, mais aussi de la solution : comme détecteur de biais d’une part, précisément grâce à sa capacité à les amplifier, et comme correcteur de biais d’autre part, dès lors qu’un tel objectif serait intégré à son cahier des charges, dans les contextes particuliers où cela serait jugé utile, sans en amoindrir la puissance ou en dénaturer la fonction.

Le défi est de taille, comme le sont les bouleversements déjà induits par l’IA dans l’ensemble de la société. La question de l’égalité devra rester centrale, et une forme de volontarisme sociétal sera nécessaire : du côté des algorithmes, avec l’implication indispensable des entreprises et des institutions, par des engagements clairs pour contrebalancer ces biais, comme #JamaisSansElles le propose désormais dans ses chartes ; et du côté humain, avec notamment l’investissement dans l’éducation et la formation tout au long de la vie, afin de sensibiliser les citoyens aux enjeux et possibles pièges qui les concernent au premier chef. Cela devra se faire avec pragmatisme, loin des discours moralisateurs ou accusateurs, trop souvent orientés vers la dénonciation d’un état de fait, plutôt que vers la mobilisation des acteurs et facteurs de changement. S’agissant des biais, il ne s’agit pas de reprocher au présent d’être l’héritier du passé, mais bien d’activer, dès maintenant, les leviers d’une transformation qui rendra l’avenir structurellement plus équitable et équilibré, économiquement viable pour tous, écologiquement soutenable, et, tout simplement, humainement désirable.

Face à l’ampleur de la tâche, il est grand temps d’arrêter de discourir sur le sexe des anges… et de commencer à (dé)coder !

Présentation de la campagne : jamaissanselles.fr/IA

Laisser un commentaire